THE COLLISION COURSE

World Scientists' Warning to Humanity

On November 18, 1992, a document titled "World Scientists' Warning to Humanity" was released, five months after the Earth Summit in Rio, the largest gathering of heads of state in history.

It was signed by over 1600 senior scientists from 71 countries, including more than half of all living Nobel Prize winners [in science].

The document began:

"Human beings and the natural world are on a collision course. Human activities inflict harsh and often irreversible damage on the environment and on critical resources. If not checked, many of our current practices put at serious risk the future that we wish for human society and the plant and animal kingdoms, and may so alter the living world that it will be unable to sustain life in the manner that we know [emphasis added]. Fundamental changes are urgent if we are to avoid the collision our present course will bring about."

El primer e incipiente grito de alarma lo dió en 1968 el Club de Roma cuándo se comenzó a notar los nefastos efectos del "collision course". Founded in 1968 at Accademia dei Lincei in Rome, Italy, the Club of Rome consists of current and former heads of state, UN bureaucrats, high-level politicians and government officials, diplomats, scientists, economists, and business leaders from around the globe. It stimulated considerable public attention in 1972 with the first report to the Club of Rome, The Limits to Growth (the Limits of Capitalism)

|

¿Evolución equivocada que nos está llevando

al Precipicio o es la equivocación

del canibalístico régimen capitalista

sin "Limits to Growth" lo que nos ha puesto en el Abismo?

...............................

Nos llevan demasiada delantera.

¿La carrera está perdida?

'It is over'?

"La Revolución Industrial y sus consecuencias han sido un desastre para la raza humana. Ha aumentado enormemente la expectativa de vida de aquellos de nosotros que vivimos en paises «avanzados», pero ha desestabilizado la sociedad, ha hecho la vida imposible, ha sometido a los seres humanos a indignidades, ha conducido a extender el sufrimiento psicológico (en el tercer mundo también el sufrimiento físico) y ha infligido un daño severo en el mundo natural. El continuo desarrollo de la tecnología empeorará la situación. Ciertamente someterá a los seres humanos a grandes indignidades e infligirá gran daño en el mundo natural, probablemente conducirá a un gran colapso social y al sufrimiento psicológico, y puede que conduzca al incremento del sufrimiento físico incluso en paises «avanzados». El sistema tecnológico-industrial puede sobrevivir o puede fracasar. Si sobrevive, PUEDE conseguir eventualmente un nivel bajo de sufrimiento físico y psicológico, pero sólo después de pasar a través de un periodo de ajuste largo y muy penoso y sólo con el coste permanente de reducir al ser humano y a otros muchos organismos vivos a productos de ingeniería y meros engranajes de la maquinaria social. Además, si el sistema sobrevive, las consecuencias serán inevitables: no hay modo de reformar o modificar el sistema así como prevenirlo de privar a la gente de libertad y autonomía. Si el sistema fracasa las consecuencias aún serán muy penosas. Pero cuanto más crezca el sistema más desastrosos serán los resultados de su fracaso, así que, si va a fracasar, será mejor que lo haga antes que después"

Theodore Kaczynski

Reg No: 04475-046

US Penitentiary MAX

P.O. Box 8500

Florence, CO. 81226-8500

USA

PD:

Le podéis escribir a ésta residencia estatal dónde transcurre su existencia; está muy bien informado; contesta a buena parte de la correspondencia que le llega --una vez pasado el filtro del Panopticon que habita--; podéis --de interesaros-- preguntarle qué piensa de éste filósofo, el cúal, por desmemoriado, o para servirle a sus mecenas, se olvida decirnos un factor importantísimo en la historia de ese PRECIPICE:

"El capital experimenta horror por la ausencia de ganancia o por una ganancia muy pequeña, como la naturaleza siente horror por el vacío. Si la ganancia es adecuada, el capital se vuelve audaz. Un 10% seguro, y se lo podrá emplear dondequiera; 20%, y se pondrá impulsivo; 50%, y llegará positivamente a la temeridad por 100% pisoteará todas las leyes humanas; por 300% y no hay crimen que lo arredre, aunque corra el riesgo de que lo ahorquen.

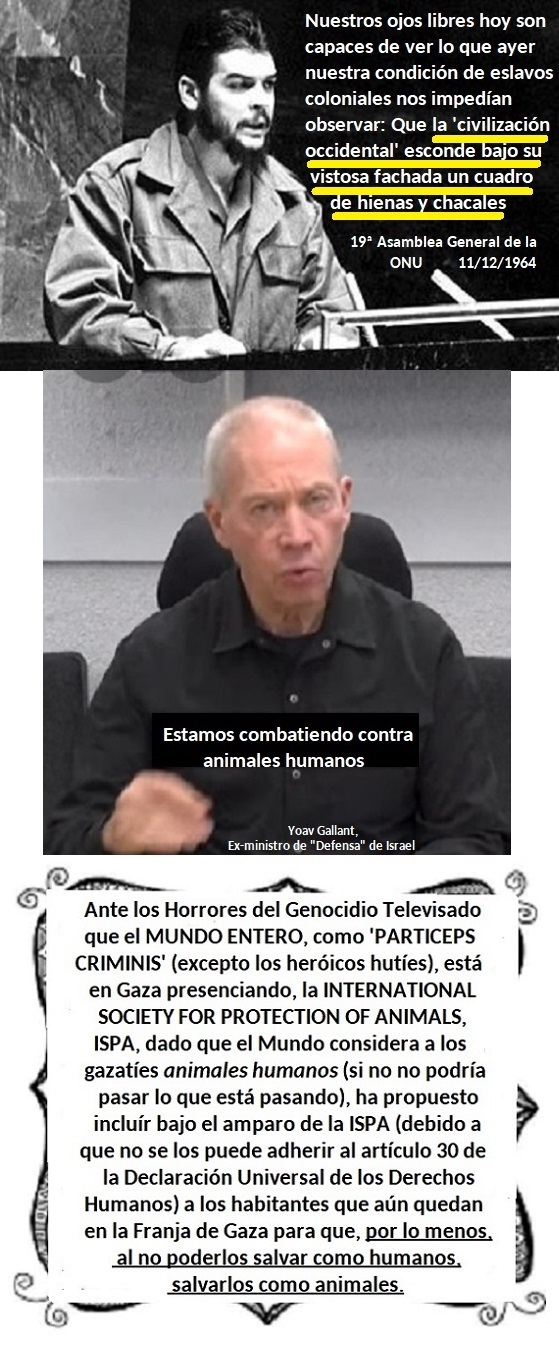

¿Es ésto lo que tendría Marx en mente

cuándo dijo que por un 300% de ganancia al capital

no hay crimen que lo arredre,

aúnque corra el riesgo de que lo ahorquen?

Pues si era ésto lo que el pensador aleman tenía en mente

fácilmente nos podemos imaginar a que nos podría llevar

el actual 10.000% de ganancias:

pues al COLAPSO DE LA CIVILIZACION,

como a continuación nos cuenta el filósofo Toby,

aunque por otros caminos muy diferentes a los

del lacerante pensador aleman, pero, no obstante, siempre

Giving What We Can, dando lo que nosotros podemos, una sociedad fundada por Toby cuyos miembros estan comprometido a donar al menos el 10% de sus ingresos a organizaciones benéficas contra la pobreza. Por ésta mera razón esperamos no estar cerca

de ese PRECIPICE para que Ord y los suyos puedan seguir

ayudando a esos que día a día viven enfrentando

el ABISMO de sus contingentes existencias.

|

|

| Toby |

Entrevista de El Confidencial

a Toby Ord

No es un guionista de Hollywood y ni un telepredicador. Toby Ord es un filósofo de la Universidad de Oxford que asesoró a la OMS y el Banco Mundial. Por eso, en vez del fin del mundo o del apocalípsis, él habla del “colapso de la civilización”.

Los matices son importantes para alguíen que se dedica a analizar las diferentes formas en que podríamos extinguirnos. Y si hay más posibilidades de que un asteroide destruya la Tierra, que de que haya una explosión supervolcánica o de que otra pandemia diezme el planeta.

En su libro ‘The Precipice’, Ord analiza al detalle cómo puede la humanidad acabar consigo misma y, lo más importante, cómo evitarlo. Su conclusión es que no es un asunto como para dejárselo a los guionistas y debería preocuparnos muy seriamente desde un punto de vista científico.

(¿Que la extinción de nuestra especie debería preocuparnos...desde un punto de vista cientifico? Hombre, desde éste punto de vista, si, hay que investigarlo, pero para tratar de solucionarlo, habría que hacerlo desde el p. de v. político-económico atacando el des-orden capitalista de producción y consumición para supeditar los intereses privados a los colectivos y humanos y planetarios estableciendo lo que estudió el Club de Roma: The Limist of Growth, los límites de robos y saqueos en pocas manos)

“Hay una posibilidad entre seis de que nos extingamos en este mismo siglo”, afirma el investigador. En este cálculo, incluye también otros “riesgos existenciales”, como un colapso que destruyera el potencial de la humanidad. “Pero prefiero ser positivo”, añade en nuestra conversación por Skype. “Eso también significa que hay cinco posibilidades entre seis de que sobrevivamos como especie”.

(Que bien. Que buena noticia. Cinco posibilidades entre seis de que no nos hundamos con el 'Titanic'. No está mal...¿Se refiere usted también a los pasajeros de primera clase? Cinco posibilidades entre seis...)

¿Tener un 80% de posibilidades de que sobreviva la civilización es realmente una buena noticia?

Más bien es una llamada de atención para tomarnos en serio los riesgos que corremos y de los que, según este filósofo, no hablamos todo lo que deberíamos.

(No hablamos todo lo que deberíamos...En España estamos justificados porque existe la Ley Mordaza y no es difícil hablar con ella --Ahora es peor porque encima tenemos la mascarilla)

Ord es en el fondo optimista, porque cree que el fin del mundo puede evitarse. La mala noticia, recuerda, es que nunca ha sido tan fácil como ahora que nos extingamos. La buena, que nunca nos hemos extinguido.

(Hombre, que ocurrencia...de habernos extinguido no estaríamos aquí ahora...; ésto es una fala-cia: recurrir a lo que no ha ocurrido para agradecer lo que ocurre. Es como si a cien metros del iceberg los pasajeros del Titanic hubieran creído que era una buena noticia que aún no habían llegado al iceberg) Su optimismo es coherente)

“Europa sobrevivió en la Edad Media perdiendo del 25 al 50% de su población en la Peste Negra, lo que podría significar que para desencadenar el colapso de la civilización requeriría más del 50% de mortalidad en todas las regiones del mundo”.

(Se requereria más del 50%...Uf...que susto. Hay esperanzas...)

En lo que respecta a las pandemias naturales, los humanos llevamos decenas de miles de años sobreviviéndolas, por lo que no cree que “sean una amenaza para la extinción, aunque puedan ser muy devastadoras”. Advierte también de que, “con el aumento de las comunicaciones globales y la superpoblación, las cosas pueden ponerse mucho peor en términos de pandemias que con el covid-19”.

Pero más peligrosas que los virus zoonóticos como el SARS-CoV-2 le parecen las amenazas potenciales de grupos terroristas que diseñen armas biológicas, una tecnología que, a diferencia de las armas nucleares, cada vez es más accesible y difícil de rastrear.

(Grupos terroristas...¡Ay!, con la iglesia topamos, Sancho! ¿Se referirá Toby a los grupos terroristas de Washington o a los grupos terroristas de la OTAN? Tendremos que preguntarselo)

“La inteligencia artificial es más peligrosa que las pandemias”, argumenta Ord. Sostiene que los humanos nunca hemos tenido tanto poder para transformar el mundo ni una tecnología tan poderosa entre manos. “Igual que las armas biológicas, la inteligencia artificial puede suponer en los próximos 50 años riesgos nuevos que aún desconocemos y en cuya prevención apenas estamos invirtiendo: la humanidad gasta más cada año en helado que en que prevenir que las nuevas tecnologías no nos destruyan”.

(La inteligencia artificial, la pobre, ¿qué culpa tendrá ella de todo éste aquelarre si sólo actúa y trabaja según los datos que le meten? A nosotros nos parece que la única inteligencia artificial que es preocupante y alarmante es la del 'homo sapiens'. Con ésta si que hay que tener cuidado, señor Toby)

Calcula el filósofo que el gasto total en reducir los riesgos existenciales de la inteligencia artificial es de decenas de millones de dólares, en comparación con los miles de millones que se gastan en mejorar sus capacidades. En otras palabras, no estamos creando nuevos escudos a la velocidad que generamos nuevas armas.

“La inteligencia artificial tiene una posibilidad entre 10 de acabar con la humanidad”, calcula Ord. “No digo que los robots sean malos”, matiza. “La Inteligencia Artificial, igual que la energía nuclear, la podemos usar para algo bueno o para algo malo, pero el problema es que todavía no hay una conciencia pública sobre sus riesgos. Los físicos en los años cuarenta y cincuenta estaban preocupados por armas nucleares y en el siglo XX los gobiernos desarrollaron protocolos de seguridad, ahora deberíamos preocuparnos más por los riesgos de la IA y las armas biológicas”.

(Las armas biológicas...buen asunto. ¿Usted no cree que para salir y distanciarnos del Preci-pice se tendrían que cerrar, ipso facto, los 400 laboratorios (Igor Nikulin) que trabajan al respecto? Claro que ésto sería una proclama política y éste Preci-pice de su libro sólo tiene que ser abordado desde el punto de vista científico, de probabilidades y estadísticas, esperando que los números al respecto favorezcan nuestas espectativas y esperas.

La mala noticia --nos recuerda Toby-- es que nunca ha sido tan fácil como ahora que nos extingamos. La buena, que nunca nos hemos extinguido. Si señor: nunca nos hemos extinguido, y esto es de agradecer)

A cada peligro que puede poner en riesgo la humanidad le ha asignado una probabilidad matemática, aunque reconoce que son cálculos difíciles de contrastar. “He analizado muchas variables, pero es verdad que no es un cálculo fácilmente comprobable y nunca estaremos seguros de ello. Obviamente no tenemos cien planetas como este para averiguar a ciencia cierta cómo de devastadora es una amenaza. Pero hay algunas certezas”.

¿Hay algo entonces que podamos hacer?

“Obviamente, sí”.

Para empezar, hablar de ello ya es un avance hacia la prevención. Tratar de medir ese riesgo cree que ayudará a tomarlo más en serio. A Ord le preocupa la poca conciencia de los riesgos devastadores que corremos y para los que habría que estarse preparando. Y, pese a que el covid-19 ha dejado claro lo vulnerables que somos a las amenazas globales, este académico de Oxford está convencido de que los gobiernos y la opinión pública seguimos sin tomarnos lo suficientemente en serio los riesgos catastróficos a los que, en mayor o menos medida, se enfrenta la humanidad. “Es complicado sacar el tema en el debate social, porque mucha gente asume que ya hay alguien haciéndose cargo de ello. Pero no es así. Algunos de los problemas más grandes a los que enfrenta la humanidad no se están afrontando. No entrar en una carrera armamentística, por ejemplo, es una cuestión política”.

(Algunos de los problemas más grandes a los que enfrenta la humanidad no se están afrontando...Es verdad. Pero, Toby, ¿no será porque los que confrontan esos problemas estan en la cárcel o aislados en confinamientos sin pandemias?)

Tampoco debe de ser el tema de conversación más sencillo que sacar en una cena cuando a uno le preguntan a qué se dedica. “En contextos informales, la gente se sorprende mucho cuando les hablas de la posibilidad de que la humanidad se extinga”. ¿Espera a los postres para comentarlo? “Hace falta algo más fuerte que un postre para sacar el tema”, bromea

(Gan sentido del humor...esperar a los postres...)

Las especies de mamíferos generalmente sobreviven alrededor de un millón de años antes de extinguirse; el Homo erectus, sobrevivió durante casi dos millones. Así que según Ord, si todo fuera bien y siguiéramos los pasos de una especie normal, podríamos aspirar a sobrevivir el millón de años que viven de media los mamíferos. “Como solo tenemos unos 200.000 años de existencia, eso nos convierte en adolescentes”, dice Ord. “Pero los adolescentes no son buenos ordenando las prioridades. No ven más allá de dentro de un rato. Y en este momento la humanidad está actuando de forma tremendamente imprudente con el futuro, como un adolescente, pensando solo en nuestras próximas cinco horas de vida. Si queremos tener cientos de miles de años de futuro, tenemos que repensar las prioridades. Eso precisa cooperar mejor entre países y reconocer que tenemos un problema y necesitamos más sabiduría”.

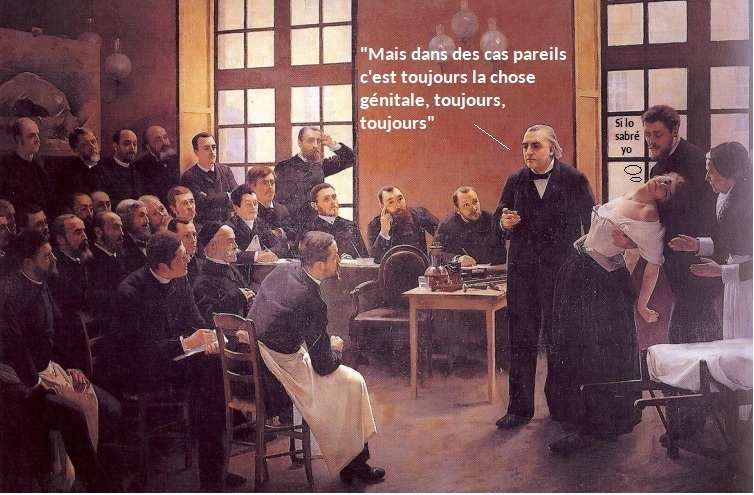

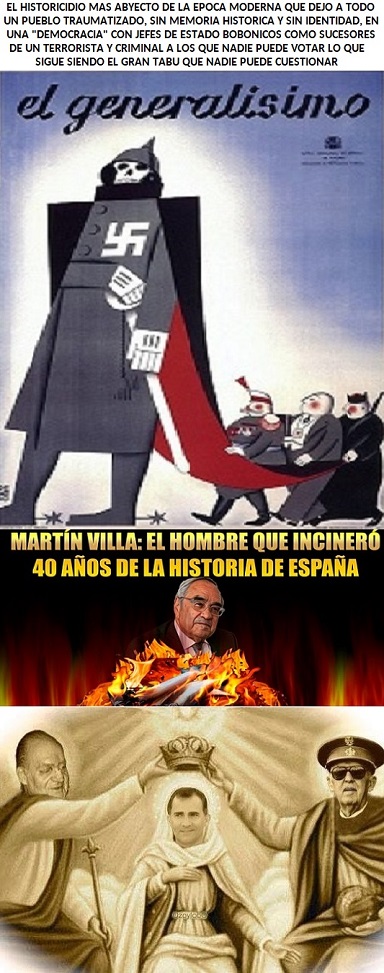

Mucho más peligrosos que los volcanes y los meteoritos son los riesgos antropocéntricos, es decir, los que están en manos humanas. Y, en concreto, de los humanos que se dedican a la política. “En otras épocas daba igual como de malos fueran los gobernantes, no tenían el poder de destruir la humanidad. Ahora sí. Necesitamos entender este poder rápidamente para poner en marcha una red de seguridad que nos proteja contra estos riesgos”.

La pandemia del coronavirus ha alimentado un boom en Estados Unidos entre los llamados ‘preppers’, los temerosos del apocalipsis que se retiran a vivir a los bosques y guardan comida en sus cabañas o construyen búnkeres inexpugnables a una guerra química. No es acumular leña la solución que propone el filósofo, porque más que adaptarse al colapso civilizatorio él propone cómo prevenirlo. “Tampoco creo que sea bueno ridiculizar a los ‘preppers’. Por lo menos ellos son conscientes de que hay un riesgo, aunque su respuesta no creo que solucione mucho. El remedio hay que ponerlo antes de que pase, no después”.

A diferencia de las películas de catástrofes, que suelen contar con un héroe que aprieta el botón correcto en el último momento, el mundo real difícilmente puede salvarse en solitario. “Hay que frenar el riesgo en primer lugar. Las amenazas son demasiado grandes y las soluciones individuales no van a evitar el problema, necesitamos invertir más en conocimiento para sobrevivir como especie”.

El problema no es tanto un exceso de tecnología como una falta de sabiduría. No solo hace falta más ciencia e investigación para prevenir los riesgos asociados a los avances científicos y tecnológicos, también más política y cooperación global. Igual que estamos inventando nuevas tecnologías hay que inventar también nuevas formas de cooperar ante las amenazas globales.

En ‘The Precipice’, Ord no resulta fatalista. No es que el destino de la humanidad sea destruirse a sí misma ni el progreso tecnológico derive necesariamente en caos. Muy al contrario, el filósofo insiste en que alejarnos del precipicio depende de las decisiones que tomemos ciudadanos y gobiernos. Además de invertir en prevención, propone una solución preliminar: “No elegir políticos que actúen como adolescentes sería un buen comienzo para garantizar el futuro de la humanidad. En otras épocas daba igual cómo de malos fueran los gobernantes, antes no tenían el poder de destruirlo todo. Y no podremos sobrevivir muchos siglos con el nivel de poder que estamos acumulando si no aumenta también la toma de conciencia del peligro. Estamos en un nivel insostenible de riesgo en manos de un grupo de adolescentes. Y los adolescentes no son buenos pensando en el largo plazo”.

("Estamos en un nivel insostenible de riesgo en manos de un grupo de adolescentes. Y los adolescentes no son buenos pensando en el largo plazo". Es verdad. Esto mismo es lo que pensamos cuándo vemos al pubescente de Trump comportarse como esos mancebos a los que hace referencia mister Ord. Estos adolescentes dislocados nunca acentaran cabeza! )